📚 文档

最后更新: 2026-02-08GPU转录

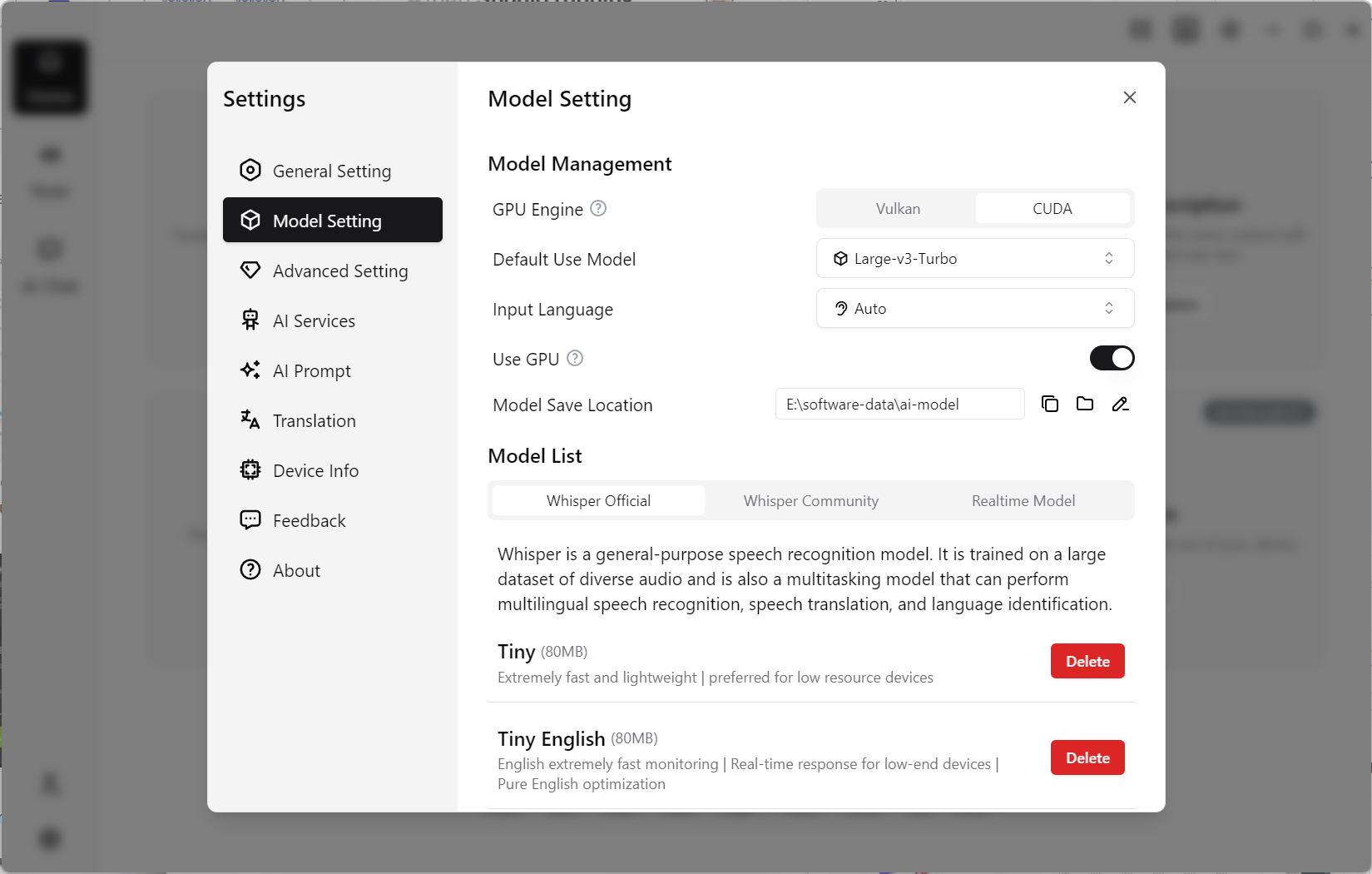

TODO(截图替换):GPU 引擎选择页(App 2.0) 建议包含:CUDA/Vulkan/CoreML 选项、当前硬件检测结果、切换后的提示信息。 建议文件名:

gpu-engine-settings-v2.png

功能边界

GPU 设置用于加速 Whisper 类模型推理。当前桌面端主要引擎:

- CUDA(Windows,NVIDIA)

- Vulkan(Windows,多厂商)

- CoreML(macOS,Apple 设备)

适用场景

- 长音频批量转录

- 大模型(Medium/Large)推理

- 需要降低处理时长与等待成本的任务

操作步骤

- 进入

设置 > 转录,找到 GPU 引擎项。 - Windows 设备按显卡厂商选择 CUDA 或 Vulkan。

- macOS 设备默认优先 CoreML。

- 运行同一素材做 CPU vs GPU 对比,确认稳定性后再作为默认配置。

- 如遇报错,先回退 CPU 验证流程,再排查驱动与运行库。

对比测试建议(避免误判)

- 同一素材、同一模型、同一语言做 CPU/GPU 对比。

- 同时记录“耗时 + 失败率”,不要只看单次速度峰值。

- 分别测试短音频和长音频,收益通常并不一致。

名词解释(首次配置常见)

- 运行库:GPU 引擎依赖的底层组件,缺失时常导致启动失败。

- 显存(VRAM):GPU 可用内存,显存不足时容易触发降速或 OOM。

- 回退路径:GPU 异常时切回 CPU 的保底方案,建议始终可用。

真实场景:每周批量会议转录提效

- 先在 CPU 跑 1 条基线,记录耗时与稳定性。

- 切到 GPU 引擎再跑同样素材,比较总耗时和失败率。

- 仅当“速度收益稳定 + 失败率可控”时,再推广给团队默认设置。

这样可以避免“看起来更快,但实际失败重跑更多”的假提效。

常见误区

- 误区 1:开启 GPU 后立即全量任务并发。

纠正:先小规模验证稳定性,再逐步放大并发。 - 误区 2:只根据显卡型号判断可用性。

纠正:驱动版本、运行库和系统更新同样关键。 - 误区 3:GPU 报错后直接放弃。

纠正:先回退 CPU 保证可用,再分步排查引擎和环境。

常见问题

Q: CUDA 和 Vulkan 怎么选?

A: NVIDIA 显卡优先 CUDA;非 NVIDIA 或兼容性问题时使用 Vulkan。

Q: macOS 下为什么没有 CUDA?

A: CUDA 仅适用于 NVIDIA 生态,macOS 主要使用 CoreML/Metal 路线。

Q: 开启 GPU 一定更快吗?

A: 大模型通常收益明显,小模型或短音频收益可能有限。

限制说明

- 引擎可用性受操作系统、驱动、显卡型号和账号能力影响。

- 首次切换 CUDA 可能需要下载相关运行库。

- 低显存设备运行大模型可能出现 OOM 或频繁降速,建议降档模型。

- 版本:Free 与 Pro 均可使用基础 GPU 能力,高级引擎或并发配额以应用内套餐标记为准。